Data Quality: cómo garantizar la fiabilidad de los datos para una analítica efectiva

Business analyticsEn un entorno empresarial cada vez más impulsado por la información, el data quality se posiciona como un pilar fundamental para la eficacia de cualquier estrategia basada en datos. La capacidad de extraer valor real depende, en gran medida, de la calidad del dato disponible. La formación especializada, como la que ofrece el Máster en Business Analytics e Inteligencia Artificial en Barcelona y Madrid, es clave para dominar estas competencias. Este programa permite comprender cómo detectar y corregir errores en datasets, aplicar técnicas de data profiling y asegurar decisiones estratégicas basadas en datos fiables. En este artículo exploramos la importancia del data quality, cómo diagnosticar problemas, qué tecnologías lo respaldan y qué perfiles profesionales están liderando este campo.

La importancia estratégica del Data Quality en proyectos analíticos

Veamos cómo la calidad del dato influye directamente en las decisiones basadas en análisis.

Cómo influye en la toma de decisiones basada en datos

Los datos son el recurso más valioso para las organizaciones modernas, pero su utilidad se disuelve si no garantizan exactitud, consistencia y actualidad. Una alta calidad del dato permite que los analistas y líderes empresariales confíen en las conclusiones derivadas de sus análisis. Por ejemplo, un dashboard financiero basado en datos defectuosos puede inducir a errores de inversión significativos. Por el contrario, una evaluación de datos constante facilita insights certeros, personalización de servicios y optimización de operaciones.

Consecuencias de una mala calidad del dato en modelos de IA

Los modelos de inteligencia artificial son especialmente sensibles a la calidad de sus datos de entrenamiento. Datos erróneos, duplicados o desactualizados pueden generar sesgos, predicciones incorrectas y pérdida de credibilidad. Por ejemplo, en el sector salud, un modelo de diagnóstico alimentado por datos con etiquetas incorrectas puede derivar en diagnósticos fallidos. Este tipo de fallos no solo afectan la eficiencia, sino también la ética y legalidad de las decisiones automatizadas.

Cómo identificar problemas de calidad del dato

Ahora exploraremos cómo identificar estos problemas antes de que afecten la analítica.

Tipos de errores frecuentes en datasets empresariales

Los errores en datasets pueden manifestarse de múltiples formas:

- Datos incompletos: Campos vacíos que impiden análisis completos.

- Datos duplicados: Registros repetidos que distorsionan estadísticas.

- Inconsistencias: Formatos o unidades distintas para el mismo tipo de dato.

- Datos incorrectos: Errores tipográficos, valores fuera de rango o mal categorizados.

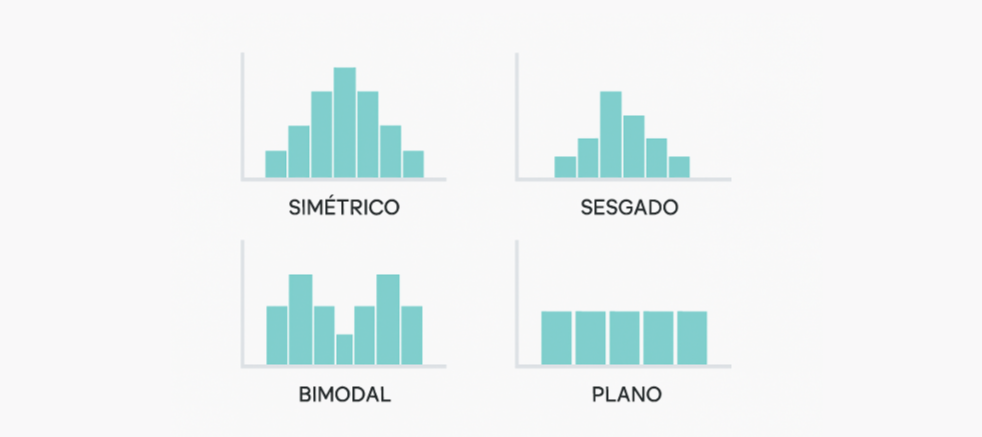

La práctica del data profiling es esencial para detectar estos errores. Esta técnica consiste en el análisis sistemático de la estructura, el contenido y la calidad de los datos antes de su uso analítico. Para profundizar, recomendamos revisar los indicadores clave de calidad de los datos, fundamentales para implementar mejoras efectivas.

Ejemplos reales de fallos y su impacto en el negocio

Un banco europeo experimentó una pérdida de millones de euros al basar decisiones crediticias en datos desactualizados sobre ingresos de clientes. Una compañía de retail reportó errores en la segmentación de clientes debido a inconsistencias en los códigos postales de sus bases de datos, lo que afectó campañas de marketing personalizadas. Estos casos demuestran cómo una débil gestión del data quality puede sabotear incluso los proyectos mejor diseñados, generando costos financieros, pérdida de reputación y pérdida de oportunidades de negocio.

Estrategias para asegurar la calidad del dato a lo largo del ciclo de vida

Una vez detectados los problemas, es esencial implementar estrategias eficaces para resolverlos.

Validaciones automáticas y limpieza de datos en tiempo real

La automatización es una de las mejores aliadas para garantizar la calidad del dato. Las validaciones en tiempo real permiten identificar errores al momento de la captura o modificación del dato, reduciendo la necesidad de correcciones posteriores. Estas validaciones pueden incluir restricciones de formato, listas de valores válidos, y verificación contra bases de datos de referencia. Además, las técnicas de data cleansing, o limpieza de datos, utilizan reglas y algoritmos para corregir, eliminar o completar datos incorrectos o incompletos antes de ser usados en análisis.

Cultura organizacional orientada al dato confiable

Más allá de la tecnología, la verdadera mejora de procesos analíticos se logra cuando toda la organización asume la responsabilidad sobre la fiabilidad de los datos. Crear una cultura de datos implica establecer políticas claras, asignar roles de responsabilidad (como los data stewards), y formar a todos los empleados en buenas prácticas de manejo y verificación del dato. Esta orientación genera una mentalidad de calidad que trasciende áreas técnicas y se convierte en parte del ADN empresarial.

Herramientas y tecnologías clave para una buena gobernanza del dato

También es importante considerar qué herramientas tecnológicas acompañan esta gobernanza.

Sistemas ETL con controles de calidad integrados

Los sistemas ETL (Extract, Transform, Load) modernos integran herramientas para asegurar la evaluación de datos en cada etapa del procesamiento. Estas plataformas permiten detectar inconsistencias, aplicar reglas de transformación uniformes y asegurar trazabilidad. Al incorporar validaciones en tiempo real durante las fases de extracción y carga, se evitan errores críticos antes de que los datos lleguen al usuario final.

Plataformas de monitoreo continuo y alertas de errores

La supervisión constante es clave en entornos donde el flujo de datos es continuo y de gran volumen. Las soluciones de data observability permiten identificar rápidamente desviaciones en métricas de calidad, activar alertas y disparar procesos automáticos de corrección. Estas plataformas son especialmente útiles en sectores como fintech o retail, donde los errores pueden impactar directamente en la experiencia del cliente y en el cumplimiento regulatorio.

Carreras y salidas profesionales vinculadas al Data Quality

Finalmente, examinemos qué oportunidades profesionales ofrece este campo en expansión.

Nuevos roles orientados a la gobernanza y fiabilidad del dato

El auge del data quality ha dado lugar a nuevos perfiles profesionales esenciales en organizaciones que apuestan por la analítica avanzada. Algunos de los más demandados incluyen:

- Data Steward: encargado de definir y aplicar estándares de calidad.

- Chief Data Officer (CDO): lidera la estrategia general de datos.

- Especialistas en Data Governance: desarrollan políticas y procesos de control.

Estos profesionales se integran tanto en equipos de IT como en áreas de negocio, actuando como puente entre tecnología y estrategia.

Formación y certificaciones recomendadas

Para quienes buscan especializarse en este campo, la formación técnica y estratégica es crucial. Los programas como el Máster en Business Analytics e Inteligencia Artificial en Barcelona y Madrid de Inesdi son una excelente opción para adquirir conocimientos prácticos sobre data profiling, herramientas ETL y gobierno del dato. Además, certificaciones internacionales como DAMA-CDMP o cursos de plataformas como Informatica, Talend o IBM aportan reconocimiento y validación profesional.

Conclusión

Garantizar la calidad del dato es un reto continuo que exige tanto soluciones tecnológicas como una cultura empresarial comprometida con la fiabilidad. Hemos visto cómo los errores en datasets pueden afectar decisiones estratégicas y cómo la evaluación de datos, herramientas ETL y una formación especializada permiten mejorar los procesos analíticos. La demanda de perfiles expertos en data quality no deja de crecer, y las organizaciones que invierten en su desarrollo se posicionan a la vanguardia de la economía basada en datos.