Los 5 algoritmos de Machine Learning más usados

Inteligencia ArtificialEl Machine Learning es una disciplina científica que forma parte del ámbito de la Inteligencia Artificial (IA). Su finalidad es crear sistemas de aprendizaje automático que se utilicen para la identificación de patrones complejos en millones de datos analizados (Big Data). Sin embargo, el funcionamiento de estas máquinas de aprendizaje se basa en la revisión y el análisis de los datos, para poder predecir patrones, es decir, comportamientos futuros. Esto se consigue gracias a los algoritmos de Machine Learning, que facilitan la toma de decisiones con una mínima intervención humana.

El uso del Machine Learning se ha incrementado en los últimos años. Tanto, que este ámbito se ha convertido en una oportunidad laboral en el mercado actual. De acuerdo con los estudios más recientes acerca del impacto de la IA en las organizaciones, el 83% de las empresas crearán nuevos puestos de trabajo a partir de la utilización de aplicaciones de IA.

¿Cómo funciona un algoritmo de Machine Learning?

Los modelos de Machine Learning son ya parte de nuestra vida real a diario, contando con numerosos ejemplos. Sin embargo, puesto que hay un gran desconocimiento sobre la manera en que funcionan, no somos realmente conscientes de ello. Por eso, queremos darte una explicación de cómo es.

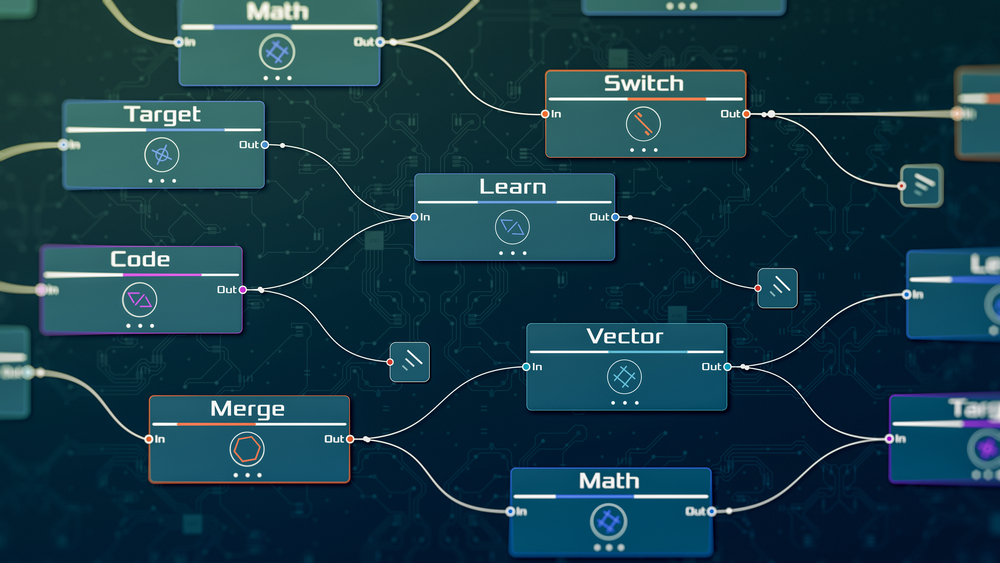

Como decíamos en la introducción, esta disciplina se basa en el uso de algoritmos, que son conjuntos de instrucciones que permiten a un sistema aprender patrones y tomar decisiones sin ser programado de forma explícita. Es decir, que pueden hacerlo por sí mismos porque han sido diseñados para ello.

El proceso general implica tres etapas: entrenamiento, validación y prueba. Durante el entrenamiento, el algoritmo se expone a datos de entrada junto con las respuestas deseadas. Lo que hace en esta fase, es ajustar sus parámetros internos para hacer predicciones más precisas. Luego, se valida utilizando datos diferentes para evaluar su rendimiento. En la última etapa, la prueba, se verifica con datos no vistos anteriormente, para garantizar su capacidad de generalización.

Dentro de los modelos de Machine Learning, podemos distinguir tres tipos. En primer lugar, el algoritmo supervisado, que es el que aprende de ejemplos etiquetados o aprendizaje supervisado. En segundo lugar, el algoritmo no supervisado, que encuentra patrones sin etiquetas. Por último, el de refuerzo, que aprende de la retroalimentación.

Los 5 algoritmos de Machine Learning más utilizados hoy en día

Los algoritmos de Machine Learning no analizan un único tipo de datos, sino que están expuestos a un repertorio muy amplio. La diversidad de estos, así como de problemas asociados, ha impulsado el desarrollo de diferentes tipos de modelos, cada uno centrado en un desafío o en un área de especialización. Aunque existen más, a continuación te dejamos los más usados.

Algoritmos de regresión

Los modelos de regresión se emplean en la predicción de valores numéricos a partir de datos históricos. Uno de los más utilizados es la regresión lineal, que modela la relación entre variables mediante una línea recta. Empresas como Amazon aprovechan estos algoritmos para prever la demanda de productos, ajustar precios y gestionar inventarios con eficiencia, para poder incrementar su productividad.

Por ejemplo, con los modelos de regresión se puede anticipar la cantidad de productos que se necesitarán en ciertos almacenes, según los patrones de compra previos. De este modo, se pueden optimizar las operaciones logísticas.

Algoritmos de agrupación

Los algoritmos de agrupación son esenciales para identificar patrones y relaciones dentro de un conjunto de datos. K-Means es un ejemplo muy conocido, que agrupa datos en clusters según las similitudes que tengan entre ellos. Aplicaciones como Google News utilizan este tipo de algoritmo para clasificar noticias y presentarlas personalizadas a los usuarios en función de cuáles sean sus intereses.

Algoritmos bayesianos

Los modelos bayesianos se basan en la teoría de la probabilidad bayesiana. Con ella, se puede modelar la incertidumbre y ajustar las predicciones en función de nuevas evidencias. Su aplicación principal se da en campos como la clasificación y filtrado de spam en correos electrónicos. Algunos ejemplos son el filtro bayesiano de spam de Gmail, que mejora la precisión al adaptarse a los patrones cambiantes de los mensajes no deseados.

Algoritmos de aprendizaje profundo

Los algoritmos de aprendizaje profundo, como las redes neuronales profundas, son muy prácticos en tareas complejas. Por ejemplo, en el reconocimiento de imágenes y el procesamiento del lenguaje natural. Empresas como Facebook utilizan estas tecnologías para mejorar las funciones de reconocimiento facial en fotos y videos, con el objetivo de personalizar la experiencia del usuario.

Algoritmos de redes neuronales

Las redes neuronales están inspiradas en el funcionamiento del cerebro y son clave en el aprendizaje profundo o deep learning. Ejemplos incluyen la red neuronal convolucional (CNN), ampliamente utilizada en visión por computador. Empresas como Tesla aplican estas redes para mejorar la capacidad de sus vehículos autónomos de interpretar y reaccionar a su entorno. Gracias a ello se está evolucionando hacia una conducción más segura y eficiente.

Cómo construir un modelo de machine learning analítico

El primer paso para construir un modelo analítico de Machine Learning es conocer adecuadamente el problema del que posteriormente obtendremos el patrón. Es decir, que habrá que controlar las denominadas entradas y salidas esperadas. Para ello, se define cuál es el objetivo y qué se intenta predecir, cuáles son las características, el problema al que nos enfrentamos, la mejora que queremos obtener al aplicar el análisis del Machine Learning y, por supuesto, de dónde obtendremos los datos.

Todo proceso de Machine Learning se define por los datos que se aportan. Por ello, son la base del éxito o del fracaso de todo el modelo analítico. Si los datos están sesgados o son erróneos, todo el modelo repetirá ese mismo patrón, por lo que siempre deben ser datos de calidad. Además, cuantos más datos obtengamos, mejor será el rendimiento del modelo que definamos.

El tercer paso es encontrar un medidor o un indicador del éxito del modelo. Si no se puede medir, no se podrá mejorar. En este sentido, hay que indicar cuáles son las pautas a medir: precisión, exactitud, rapidez, magnitud, etc.

El siguiente paso es definir un patrón para observar los datos, con base en los objetivos que se hayan definido en el paso anterior. Como ejemplo, podemos hablar de diferentes patrones que nos permitirán solucionar unos problemas u otros.

En cuanto a los protocolos de actuación, los más conocidos son:

- Hold Out o set de validación, que consiste en mantener aparte una porción de los datos como conjunto de datos de prueba

- Validación K-Fold, que consiste en dividir los datos en K particiones del mismo tamaño. Para cada partición i, el modelo es entrenado con las restantes K-1 particiones, y evaluado en la propia partición i.

- Validación Iterada K-Fold con arrastre, se suele utilizar en los casos en los que no se cuenta con suficiente cantidad de datos. Consiste en aplicar la validación K-Fold varias veces, y “arrastrar” los datos cada vez antes de dividirlos en K particiones.

El quinto paso es la preparación de los datos. En esta etapa, se aportan patrones como:

- Qué hacer con los datos que se encuentran mal recogidos o que no tienen todos los campos bien definidos

- Diferenciar entre datos nominales y datos categóricos

- Escalación y selección de características relevantes.

- División de los datos en conjuntos de entrenamiento, validación y pruebas.

Para ello, hay diferentes métodos de trabajo que ayudan a pulir los datos hasta obtener un resultado que el modelo puede procesar.

Con los datos preparados, se puede desarrollar un modelo de base. Aunque no será el definitivo, sirve como referencia para medir el rendimiento del algoritmo y realizar ajustes. Para ello, los experimentos deben ser comparables, medibles y reproducibles.

Una vez identificado el modelo y definidos los pasos, se empieza a ejecutar el modelo analítico que hemos creado y a obtener resultados. Sin embargo, hay que entrenar a la máquina para visualizar mejoras en el funcionamiento y someter a los modelos a evaluaciones regulares para comprobar la utilidad. Superadas todas estas fases, se llega al modelo definitivo de Machine Learning, que realizará predicciones reales en la vida real.